AIに利用規約を分析させてみた!GeminiとChatGPTの違いと自衛術

公開日:

※当サイトはアフィリエイトプログラムを利用しています。

先日こちらの記事に「規約を読むのが面倒なら、AIに利用規約を分析してもらうといいよ」と書きました。

AI利用規約を読まずに同意しては危険!あなたの存在がなくなるかも

そこで、どんな結果が出るのか、GoogleとOpenAIで実験。

Googleは「学習に使うし、人間も見ることがあるよ。でも日本の法律で守るよ」という管理型。

一方OpenAIは「権利はユーザーにあげるよ。でもトラブルがあったらアメリカのルールでね」という自己責任・譲渡型という感じになりましたね。

「GeminiやChatGPTを使ってるけど、規約を全然読んでない」そこのあなた(笑)。

リスクになりそうな部分だけ抜き出してますから、その部分だけでも読んで行ってくださいね!

Gemini利用における主要リスク分析

まずは、Geminiのプライバシーに関する規約です。

Geminiの「設定とヘルプ」から「プライバシー」を選択すると、「Gemini アプリのプライバシー ハブ」が表示されますので、全部コピー。

Geminiにペーストし、こちらの質問(プロンプト)を入力。

※このページ以外にもいくつかの規約があります。

AIへの質問(プロンプト)の例です。コピペしてそのまま使えます。

「以下の利用規約を分析し、1.自動課金の有無、2.入力データの再利用(学習)の有無、3.解約の難易度、4.著作権の帰属先について、一般ユーザーが注意すべきリスクを箇条書きで教えてください。」

Googleの分析結果 4つの重要項目

1. 自動課金の有無

⚠️無料版と有料版の混在

規約内に「Geminiのサブスクリプションを利用している場合は」との記載があり、特定の高度な機能については有料プラン(サブスクリプション制)が存在します。

⚠️自動更新のリスク

一般的なGoogleサービスの慣例として、一度有料プランに登録すると、手動で解約しない限り自動的に課金が継続される仕組みです。

2. 入力データの再利用(学習・人間による閲覧)

この項目がプライバシー上の最大のリスクです。

⚠️モデル改善への利用

入力したプロンプト、ファイル、回答内容は、Googleの生成AIモデルや機械学習技術の改良に使用されます。

⚠️人間によるレビュー

サービスの維持・改良のため、人間のレビュアーがデータの一部を閲覧・注釈付けすることがあります。

⚠️機密情報の入力禁止

規約には「レビュアーに見られたくない機密情報や、改善に使用されたくない情報は入力しないでください」と明記されています。一度人間がレビューしたデータは、本体のアクティビティを削除しても最大3年間保持されます。

「本体のアクティビティを削除しても最大3年間保持」に関しては、下記に詳しく書いていますので、先に読みたい方はタップすれば該当箇所に飛べます。

3. 解約の難易度

✅アクティビティ管理は容易

「Gemini アプリ アクティビティ」の設定から、履歴の削除や自動削除期間(3ヶ月〜36ヶ月)の変更、学習への利用停止などはユーザー自身で比較的容易に設定可能です。

⚠️完全な消去の困難さ

人間のレビュアーに渡ったデータや、セキュリティ・法的理由で保持されるデータは、アカウントや履歴を削除しても即座には消えません。

⚠️サブスクリプション解約

Google PlayストアやGoogle Oneの設定画面から行う必要があり、アプリをアンインストールしただけでは解約(課金停止)になりません。

4. 著作権の帰属先

⚠️生成コンテンツの性質

規約には「生成される情報は不正確または不適切な場合がある」とあり、情報の正確性は保証されていません。

⚠️権利の制限

「ご自身が権利を有しているコンテンツに対してのみアップロードや編集を行ってください」とあり、他者の権利(著作権など)を侵害するような利用は禁止されています。

⚠️帰属の明示

一般的にGoogleのAI規約では、生成物の権利をユーザーに認めつつも、サービス提供や改善のためにGoogleがそれを利用する広範なライセンスをユーザーが許諾する形をとることが多いため、商用利用などの際は最新の具体的な利用規約を別途確認する必要があります。

💡最も注意すべきは

プライベートな情報や仕事の機密をチャットに送らないこと。

設定で「アクティビティの保存」をオフにしても、一時的な応答や安全性確認のためにデータは処理されます。

Googleの3年間の壁とデジタル・タトゥー

履歴を消せば、データは全て消えると信じているあなたに、Googleの規約は残酷な現実を突きつけています。

なぜ「消したはず」のデータが残るのか?

私たちがGeminiに入力した内容は、以下の2つのルートに分かれます。

ルートA(デジタル履歴)

あなたのアカウントに紐付いた「チャット履歴」。これはあなたが削除すれば画面上からは消えます。

ルートB(学習サンプル)

Googleが「AIの精度を上げるために、人間がチェックしよう」とピックアップした一部の会話データ。

衝撃的なのは、一度「ルートB」に選ばれて人間のレビュアー(評価担当者)の手に渡ったデータは、あなたが自分の履歴を消しても削除されないという点。

Googleはこれを「アカウントとは切り離された状態で最長3年間保持する」と明記しています。

また、Googleは「匿名化するから安心だ」と説明していますが、大きな落とし穴があります。

アカウント名は伏せられても、「入力内容そのもの」は伏せられないから。

プロンプトの内容が具体的であればあるほど、パズルのピースが埋まるように「あ、これはあの会社のあの案件だな」と推測できてしまうというわけですね。

例えば「福岡のIT企業で、最近〇〇という新技術を導入したリーダーとしての悩み」これだけで、業界人が見れば「あ、あのチームの誰々さんだ」と特定するのに十分なヒントになる可能性が高いのです。

AI時代はハイブリッド確認とぼかしで自衛

💡「ハイブリッド確認」とは?

AIのスピード × 人間の判断力 = 最強の自衛術

① AIでスクリーニング(重要4項目を数秒で抽出)

↓

② 人間が原文確認(怪しい部分だけチェック)

↓

③ 対話で深掘り(「自分の場合は?」と質問)

このリスクを知った上で、私たちはどうAIと付き合うべきなのでしょうか。最強の自衛手段は「AIを信じ切らないこと」です。

① 人の目も入れる

規約を全て読むのは無理でも、AIに「お金・権利・プライバシー・裁判」の4項目を抽出させることで、リスクの輪郭は数秒で掴めます。

もちろん、AIが「怪しい」と指摘した部分は、必ず自分の目で「原文を確認」することが重要です。

ニュアンスが微妙にずれていることもあるため、できれば1種類のAIだけでなく、複数のAIを使うと精度が高くなります。

② 入力内容を抽象化する

AIへの入力は、「地域の掲示板に匿名で書くお悩み相談」みたいなものだと思ってください。

誰だか分からないように書いたつもりでも、詳しすぎると特定される可能性があります。

それを防ぐために、内容を抽象化、ぼやかしてAIに伝えましょう。

| 入力レベル | リスクの高い例(具体的) | 自衛した例(抽象化) |

|---|---|---|

| 固有名詞 | 「プロジェクト・サクラ」の資料作成 | 「新製品のプロモーション」の資料作成 |

| 場所・組織 | 「福岡市中央区の〇〇商事」で…… | 「地方都市の中堅商社」で…… |

| 具体的な数字 | 「予算3,450万円、期間6ヶ月」 | 「数千万円規模、半年間のプロジェクト」 |

Geminiとの会話は密室の独り言ではなく、誰でも閲覧でき、3年間保管される。

こう考えれば、うっかりあなたの個人情報など機密情報をGeminiに漏らすことはしないでしょう。

ChatGPT利用における主要リスク分析

次にChatGPTに関する利用規約です。

ChatGPTからだと、どこに規約があるのかわからなかったので、まず規約の場所をChatGPTに教えてもらうことから始めました。

「本利用規約は、ChatGPT、DALL·E、OpenAIの個人向けその他のサービス、及び関連するソフトウェアアプリケーション及びウェブサイト(以下、総称して『本サービス』といいます)に適用されます。」とあります。

また、このページ以外にも「サービス利用規約」や「プライバシーポリシー」など、いくつかの規約があります。

OpenAIの利用規約 を全部コピーして、Geminiにペースト。

AIへの質問(プロンプト)の例です。コピペしてそのまま使えます。

「以下の利用規約を分析し、1.自動課金の有無、2.入力データの再利用(学習)の有無、3.解約の難易度、4.著作権の帰属先について、一般ユーザーが注意すべきリスクを箇条書きで教えてください。」

ChatGPTの分析結果:4つの重要項目

1. 自動課金の有無

⚠️サブスクリプションの自動更新

有料プラン(ChatGPT Plusなど)に登録した場合、解約しない限り「解除されるまで自動的に請求される」ことが明記されています。

⚠️価格変更の可能性

30日前の通知をもって価格を値上げする権利をOpenAIが保持しています。

⚠️返金不可

法令で義務付けられている場合を除き、支払った料金は原則として返金されません。

2. 入力データの再利用(学習)の有無

⚠️デフォルトで学習に利用

「当社は、本サービスの開発・改善などのために、本コンテンツ(入力と出力)を使用する場合がある」とされています。

✅オプトアウト(停止)は可能

ユーザーが設定や特定のフォームから申請することで、自分のデータを学習に使用させないよう制限できます。ただし、その場合はサービスの性能が制限される可能性があると警告されています。

⚠️機密保持の責任

入力データに関してはユーザーが一切の責任を負うため、秘密情報の入力はリスクとなります。

3. 解約の難易度

✅解約手続き自体は可能

いつでも有料サブスクリプションを解除できるとされています。

⚠️アカウントの終了・停止

OpenAI側は、規約違反や1年間の未利用(無料アカウントの場合)を理由に、一方的にアカウントを削除する権利を持っています。

⚠️データの削除

アカウントを削除しても、すでに学習プロセスに組み込まれたデータや、法的義務で保持されるデータの完全な消去については、この規約上では詳細な保証はありません。

4. 著作権の帰属先

✅ユーザーへの所有権譲渡

規約上、「OpenAIはアウトプットに関する権利をお客様(ユーザー)に譲渡します」と明記されており、法律で認められる範囲でユーザーが所有権を持ちます。

⚠️類似性のリスク

AIの性質上、他のユーザーに全く同じ回答が出る可能性があり、その「他人の回答」に対しては権利を主張できません。

⚠️責任の所在

出力結果が他者の権利(著作権など)を侵害していないか確認する責任はユーザーにあります。AIが生成したものを「人間が作った」と偽って公開することは禁止されています。

特に注意すべき法的な壁

OpenAIの規約には、日本のユーザーにとって非常に重要な「法的な壁」が含まれています。

強制仲裁と集団訴訟の放棄

万が一トラブルになり裁判を起こしたくても、原則として裁判ではなく「仲裁(話し合い)」で解決することに合意させられます。

また、他のユーザーと一緒に訴える「集団訴訟」に参加する権利も放棄することになります。

裁判地はサンフランシスコ

係争が生じた場合、カリフォルニア州サンフランシスコの裁判所が管轄となります。

日本から法的に争うのは極めて困難です。

私のような福岡のユーザーからすれば、相手は東京どころか海の向こう。

しかも、単なる裁判ではなく「仲裁(裁判抜きでの話し合い)」を強制されるため、日本の司法の保護が届きにくい「完全なアウェイ」です。

ただこれは、法律の大原則「訴える側が、訴えられる側(被告)の住所地まで出向く」(被告地主義)からすれば至極当然で、OpenAIがおかしいわけではありません。

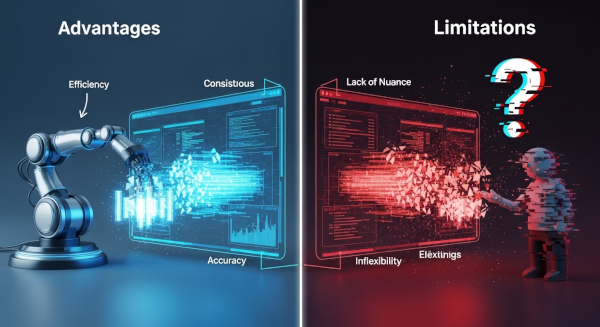

AIに規約を読ませる利点と限界

「AIによる規約分析はどこまで信じられるのか?」「規約をAIに読み解かせる」という実験から見えた、メリットとリスクをまとめてみました。

AIに規約を読ませるメリット

私たち人間が規約を読むとき、最も苦労するのは何が重要かを見極めることです。

膨大な作業の自動化

数万文字に及ぶ規約のほとんどは定型文ですが、その中に数行だけ「ユーザーに不利な条件」が紛れ込んでいる場合があります。

今回の例なら、人間なら30分かけても見落としそうな「裁判はアメリカ」「データは3年保持」といったリスクをAIなら数秒で特定できます。

専門用語の翻訳

「専属的合意管轄」や「強制仲裁条項」といった、一般人には理解しづらい法律用語を、わかりやすい言葉に置き換えられるのが最大の強みです。

質問できる

規約を読む途中で「これはどういう意味なんだろう?」と感じたとき、AIに質問しながら理解できるので、スルーしてしまうこともありません。

「もっとかみ砕いて教えて」などの質問を挟むと、記憶にも残りやすくなります。

AI分析の限界を理解しておく

AIは便利なツールですが、決して万能ではありません。特に見落としがちな3つの死角に焦点を当ててみます。

責任までは読み解けない

責任の取り方は、企業によって違います。

規約に並んだ言葉を追うだけでは、その企業がどの範囲まで守ってくれるのか、どこからが自己責任なのかという「境界線」が見えにくい場合があります。

こうした法的免責の細かいニュアンスや、ユーザーに突きつけられた責任の重さを正しく評価するのは、AIにはまだ難しい領域なのです。

責任の境界線を正しく理解する

規約に「医療・法律・財務の助言ではない」と書かれてる場合が多いですよね。

この「助言ではない」という一文は、企業が負える責任の範囲を明確にする法的免責の境界線として機能しています。

企業のスタンスとして、「AIは高度な情報を提供しますが、それはあくまで『参考情報』としての提供です。

最終的な判断による結果については、ユーザーご自身が責任を持つというルールに同意してください」ということ。

AIに規約を分析させると、AI自身がこの「責任の重さ」や「境界線の厳しさ」を標準的な定型文として軽く見積もって報告する傾向があるため、その裏にある「ユーザーが負うべき判断の重み」を私たちは忘れてはなりません。

サービスを支える責任の限界

「書かれていないこと」の正体

AIは目の前のテキストから情報を拾い出すのは得意ですが、私たちが「サービスとして当然あるはず」と期待している保護が、実は規約から欠落していることまでは指摘してくれません。例えばこういったことですね。

🔖補償の上限(責任の制限)

「損害が出たら、誠意を持って補償してくれるはず」と期待したくなりますが、規約上は「最大100ドル(約1.5万円)まで」といった具体的な上限が定められていることが一般的です。

これは、AIという未知のサービスを安価に提供し続けるために企業が設定している「責任の許容範囲」ですが、難解な法律用語の中に置かれているため、AIの要約では見落とされがちです。

🔖現状有姿(現状渡し)

「不完全な状態であることを承諾して使う」という宣言です。

AIが誤った情報を出力したり、一時的に不安定になったりしても、企業はそれを「織り込み済みの仕様」として提供しています。

現状有姿を噛み砕くと

このAIは常に進化の途中にあり、完璧ではありません。

・情報の正確性を保証するものではない

・予期せぬ中断が起きる可能性がある

・それによる損害の補填は行わない

こうした「サービス提供側の責任の限界」を理解した上で、納得して使ってくださいね。 → つまり、究極の「自己責任のツール」であるという宣言です。

情報の鮮度とハルシネーション

🔖法改正とのズレ

AIの知識が古いと、最新の法改正(日本の消費者契約法など)で見直された項目を「有効」と答えてしまうことがあります。

🔖もっともらしい嘘(ハルシネーション)

規約のような厳格な文書でも、AIが「存在しない条項」を捏造したり、意味を真逆に解釈したりする可能性はゼロではありません。

私たちが同意の裏で選んでいるもの

AIに規約を分析させて分かったのは、私たちが「同意」ボタンをクリックするその瞬間、単に便利なツールを選んでいるだけでなく、万が一の際の自分の運命を選んでいるということなんですね。

例えば、OpenAIを選ぶと 「生成物の権利」という果実を手に入れる代わりに、何かあれば英語で、サンフランシスコという遠い異国の地で戦う「覚悟」を持つということ。

守るためのコストが被害額を上回る可能性がある以上、それは実質的に「自分の身は自分で守り切る」という孤高の自己責任を選んでいることになります。

一方、Googleを選ぶと 「日本の法律」という馴染みのある防波堤の中で守られる代わりに、自分のデータがGoogleという巨大な管理システムの一部となり、3年間は誰かの目に触れる可能性があることを受け入れるということ。

それは「プライバシーを一部預けて、安心を買う」という管理型の契約を選んでいることになります。

どちらが優れているかではなく、大切なのは「自分がどちらのルールの上に立っているか」を自覚して使い分けることです。

AIに相談はしても、決断までは委ねない。

この一線を引くだけで、あなたの入力するプロンプトは、もっと確かなものに変わるはずです。

AIを優秀な秘書にする

AIは「行間を読む」能力も向上していますが、最終的にあなた自身を守るのは「あなた自身の目」だけ。

AIに丸投げするのではなく、以下のようなステップで確認すると良いでしょう。

AIによるスクリーニング

まずAIに読ませて「お金・権利・プライバシー・裁判」の4項目を抽出させ、リスクの輪郭を掴む。

人の目で確認

AIが「ここが怪しい」と指摘した部分だけ、原文を自分の目で確認する。

対話による深掘り

「もし私が福岡でトラブルにあったら、この規約のせいでどんな困ったことが起きる?」といった、自分の状況に当てはめた質問をAIに投げて、具体的なリスクをシミュレーションする。

AIに規約を読ませること自体は、タイパもコスパも良く、時間に追われる毎日を過ごすあなたには強い味方です。

でも、AIが出した答えはあくまで『下書き』。

それを鵜呑みにせず、最後に自分の価値観で「この条件で同意していいか?」を判断する。

AIのスピードと人間の直感を組み合わせた「ハイブリッド確認」が、あなたの存在と権利を守る最強の自衛手段になるのです。

関連記事

【AIがあなたの情報を盗む時代】個人でできるサイバーセキュリティ

AI利用規約を読まずに同意しては危険!あなたの存在がなくなるかも